Les escroqueries modernes utilisant les deepfakes présentent des défis majeurs pour le secteur de la cybersécurité, mais aussi des opportunités tout aussi considérables.

Par Pictet Asset Management.

Quatre milliards de personnes voteront en 2024, ce qui en fait une année électorale inédite dans l’histoire. Malheureusement, cette abondance de scrutins coïncide avec l’entrée dans l’ère des deepfakes alimentés par l’intelligence artificielle qui pourraient diffuser de fausses informations auprès des électeurs encore indécis.

Un deepfake est une forme de média artificiel qui reproduit l’apparence d’une personne à l’aide d’une technique d’IA appelée deep learning ou apprentissage profond. Cet hypertrucage est obtenu en entraînant un modèle d’apprentissage automatique à l’aide d’un grand ensemble de données image ou vidéo d’une personne, telle qu’un candidat politique ou un dirigeant d’entreprise, pour apprendre et dupliquer les traits qui lui sont propres. Plus le volume de données disponibles est important, plus le trucage est réaliste, c’est pourquoi les politiciens et les célébrités figurent parmi les cibles les plus exposées. L’augmentation des risques de deepfake nourrit la demande en investissements dans une cybersécurité de haut niveau.

En Slovaquie, l’année dernière, un hypertrucage audio d’un candidat à l’élection discutant des moyens de manipuler le scrutin a été diffusé 48 heures avant l’ouverture des bureaux de vote, ce qui n’a pas laissé assez de temps pour désamorcer la menace qu’il représentait. De même, en janvier, au Bangladesh, une vidéo générée par l’IA a été diffusée le jour des élections dans laquelle un candidat indépendant annonçait son retrait du scrutin. Le même mois, des électeurs américains ont reçu des «robocalls». Ces programmes informatiques ont imité la voix du président américain Joe Biden et ont demandé aux personnes de ne pas aller voter à la primaire présidentielle de leur état. Des personnalités politiques américaines ont reconnu l’urgence d’investir. Lorsque 400 millions de dollars ont été alloués à la sécurité des élections en 2020, elles ont été nombreuses au niveau fédéral a explicitement mettre l’accent sur la cybersécurité dans leurs demandes de subventions.

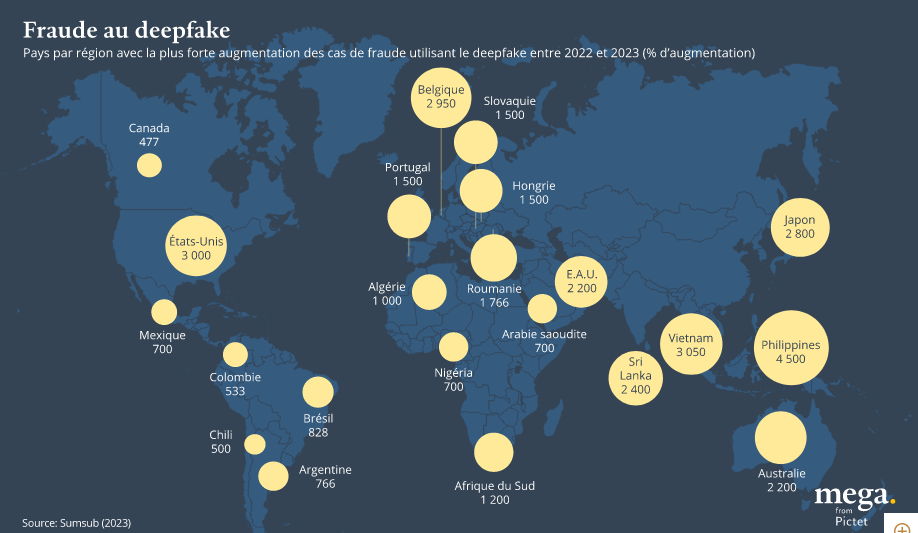

Les deepfakes ne se contentent pas d’entrer dans l’arène politique. Une enquête a révélé que 66% des professionnels de la cybersécurité ont vu des deepfakes utilisés dans le cadre d’une cyberattaque en 20221. La même année, 26% des petites entreprises et 38% des grandes entreprises ont été prises pour cible d’un détournement d’identité généré par l’IA2. Une entreprise a récemment perdu 25,6 millions de dollars en raison d’une arnaque dans laquelle une fausse vidéo montrait son directeur financier demander des fonds à un employé.

En un an seulement, entre 2019 et 2020, la quantité de contenus en ligne provenant de deepfakes a augmenté de 900%3. D’ici 2026, la grande majorité des contenus en ligne pourrait être générée de manière artificiel, ce qui rendra plus difficile la distinction entre les contenus authentiques et les contenus frauduleux générés par l’IA.

«La sphère générative s’améliore de jour en jour, de sorte que la qualité et le réalisme des deepfakes s’améliorent également», explique Ilke Demir, chercheuse chez Intel Studios. Les entreprises accélèrent leurs investissements dans les technologies de cybersécurité afin d’avoir une longueur d’avance sur les acteurs malveillants, avec un dixième des dépenses informatiques consacrées en moyenne à la cybersécurité en 20224. Le cabinet de conseil McKinsey estime que cette demande a créé une opportunité de marché de 2 000 milliards de dollars pour les fournisseurs de cybersécurité.

Défense contre les deepfakes

Pourtant, les acteurs malveillants mènent toujours la danse. «C’est le jeu du chat et de la souris, et pour l’instant, la quantité de ressources investies dans le développement de nouvelles formes de contenu génératif est nettement supérieure à la quantité investie dans le développement de techniques de détection fiable», déclare Henry Ajder, conseiller expert en deepfakes et IA.

Les outils de détection des deepfakes évoluent en permanence et s’adaptent à de nouveaux contextes. Par exemple, beaucoup ont traditionnellement été entraînés avec des données occidentales, mais la police sud-coréenne a développé un logiciel reposant sur des données coréennes avant les élections. Cet outil utilisera l’IA pour comparer les impostures potentielles à des contenus existants afin de déterminer si elles ont été manipulées à l’aide de techniques de deepfake. La police sud-coréenne annonce un taux de précision de 80%.

De nombreux outils de détection adoptent cette approche d’identification des manipulations en cherchant à repérer les petites impuretés dans l’audio et la vidéo. Mais l’une des techniques les plus efficaces à ce jour prend le contrepied de cette approche. Elles partent des qualités uniques de vidéos réelles que les deepfakes ne peuvent pas prendre en compte. Le «FakeCatcher» d’Intel est un outil d’avenir qui identifie les fausses images de personnes à l’aide de la photopléthysmographie (PPG), une technique qui détecte les changements de la circulation sanguine dans le visage. «Lorsque le cœur pompe le sang dans les veines, les veines changent de couleur», explique Ilke Demir à l’origine de l’idée. «Cela n’est pas visible à l’œil nu, mais un ordinateur peut le voir.»

Le logiciel collecte les signaux PPG de tous les endroits du visage et crée des cartographies à partir des propriétés spatiales et temporelles de ces signaux. Ces cartes sont utilisées pour former un réseau neuronal afin de dire si une vidéo est vraie ou fausse. Selon Mme Demir, l’avantage de ce logiciel est que les signaux PPG ne peuvent pas être reproduits. «Il n’existe pas d’approche qui puisse l’intégrer à un modèle génératif et essayer de l’apprendre», explique-t-elle. «C’est ce qui explique la grande fiabilité de FakeCatcher.»

FakeCatcher présente un taux de précision de 96%. La chaîne de télévision britannique BBC a testé la technologie sur de vraies et fausses vidéos et a constaté qu’elle identifiait correctement toutes les vidéos, à l’exception d’une seule. Cependant, elle a également généré quelques faux positifs, considérant de vraies vidéos comme des fausses en raison d’une mauvaise pixellisation ou parce que l’angle de prise de vue était sur le côté. «Nous essayons de fournir autant de résultats interprétables que possible», explique Mme Demir. «L’utilisateur du système doit prendre la décision finale en examinant les différents signaux.»

Henry Ajder affirme que chaque approche de détection de deepfake à ses avantages et ses inconvénients. Pour lui, l’initiative de la Coalition for Content Provenance and Authenticity (C2PA) est prometteuse. Il s’agit d’une signature numérique qui bénéficie de l’aval de géants du secteur comme Google, Intel et Microsoft. «Des technologies capables d’ajouter des métadonnées cryptoprotégées existent. Elles fournissent de la transparence sur la façon dont un support a été créé et les outils utilisés», explique-t-il. «C’est de loin la meilleure approche à des fins de sécurité, mais c’est une tâche vraiment ambitieuse.»

La C2PA est en train d’établir une norme pour attacher les références des contenus. «Ces technologies ont véritablement le vent en poupe», explique Ajder. «Mais s’il n’y a pas de coopération et d’harmonisation à grande échelle, en particulier entre les grandes entreprises, nous finirons par avoir trop de produits et de plateformes d’authentification différents, ce qui compliquera la vie des consommateurs.»

De plus, bien que cette approche présente des avantages, elle pourrait poser des problèmes éthiques en matière de confidentialité. Qu’en est-il si la norme révèle trop de données sur la provenance de l’image, comme l’endroit ou l’heure où elle a été prise. Cela peut représenter un risque de sécurité par exemple pour les actions d’une organisation de défense des droits humains.

Henry Ajder ajoute que la technologie seule ne peut jamais résoudre complètement le problème du deepfake et que tous les consommateurs devront adopter une vision plus critique des médias qu’ils consomment. «Nous devons changer notre comportement en tant que consommateurs. Au lieu de faire confiance à tout ce que nous voyons, nous devrons trouver un endroit où chercher les références des contenus et obtenir une couche d’authentification supplémentaire», explique-t-il. «Et nous en sommes encore loin.»

[1] VMware Inc, «Global incident response threat report», 2022

[2] Regula, «The state of identity verification in 2023»

[3] Sentinel, «Deepfakes 2020 : the tipping point»

[4] Ians, Artico, «Security budget benchmark summary report 2022»